AI PCとしてMacが最適な理由

Macと機械学習の相性の良さ、ご存じですか?

2023年、Chat GPTの登場で一気に注目が集まった大規模言語モデル(LLM)。

画像や映像処理を行う生成AIも、まさに日進月歩でアップデートのニュースが相次いでいます。

AI元年と呼ばれた時代を越え、これから仕事でAIワークフローの構築や活用を行いたいと興味を持つ方も急増中です。

実はこうした機械学習は、Macと相性が非常に良いとされています。

その主な理由は、Macの【高パフォーマンスのNPU】と【ユニファイドメモリ】です。

AI PCとは何か、そしてなぜMacは優れたAI PCと言えるのか。M3チップデバイスを例に、詳細をご紹介します!

2024年6月追記:今年のWWDCでは、「Apple Intelligence」が発表されました!

2024年秋にリリース予定のmacOS Sequoia, iOS 18には、iPhone・iPad・Macのためのパーソナルインテリジェンスシステム「Apple Intelligence」が搭載されます。

文章の提案や校正、画像生成、優先度の高い情報のピックアップなど、アプリを横断して利用できる新機能の数々が発表されました。

オンデバイス(ローカル)処理を原則とし、ChatGPT 4oと連携して処理することも可能とのことです。

※なお、日本語を含む英語以外の対応は来年2025年以降になるとされています。

機械学習に必要な能力を持つ「AI PC」とは

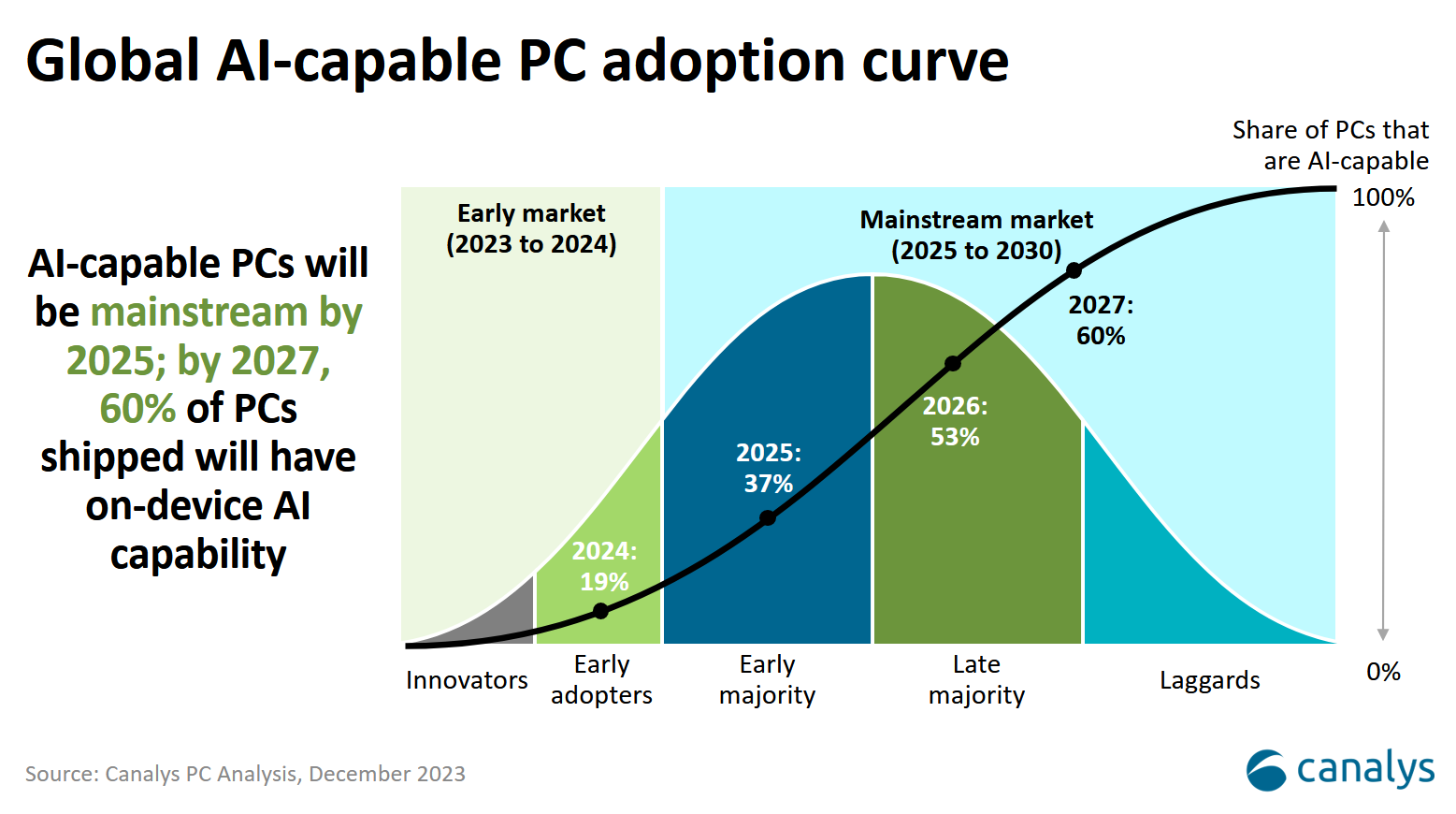

米調査会社Canalysによると、2027年までに出荷されるPCの60%がAI対応PCになると予測されています。

※Canalysの定義するAI対応PCとは、AIワークフローを"ローカル処理する能力を持つ"パーソナルコンピュータを指します。

現在Microsoft Copilotを初めとする機械学習の殆どは100%クラウドで実行されていますが、技術の進化により、近い将来ローカルのオンデバイスまたはハイブリッド処理に移行していくとの予測が立っています。

実際にローカルの大規模言語モデル(LLM)は、2024年前半で既により賢く、実用的に進化を遂げました。

ローカル移行が進んでいくと、データをデバイスに保持してセキュリティを担保しつつ、遅延の低減と、かなりのコスト削減を見込むことができるでしょう。

いずれもビジネスシーンにはとても重要な項目です。

つまりこの先活躍するPCには、「高い能力を持つローカルのニューラルプロセッサ」と、「膨大なデータを処理するのに十分なメモリ(GPU)容量」が要求されると言えます。

※AIの処理には、並列処理を得意とし、膨大な計算を高速実行できるGPUが主に利用されます。

MacのNPU “Neural Engine”

Appleは2017年発売のiPhone XにA11 Bionicチップを搭載しました。

この新たなチップには、機械学習とAIの演算処理に特化した毎秒6,000億回の演算処理を実行する"Neural Engine"という新機構が反映され、Face ID等の実行に寄与しています。

そして2020年、MacのチップはAppleシリコンシリーズに進化を遂げました。

以降、M1から最新のM3 Maxまで全世代がNeural Engine、つまり機械学習とAIのワークフローを加速させるNPUを搭載しています。

MacBook Pro(14-inch,16-inch)

そのパフォーマンスは2017年当初0.6TOPS*であったところ、第3世代となるM3チップでは30倍の【19TOPS】まで向上。この大きな進歩は、Appleが他社に先んじてNPU搭載コンピュータの量販に取り組んできた成果と言えます。

*TOPS:1秒間に実行できる演算回数を1兆回毎で表す単位。

Appleシリコンの強み

Neural Engineだけでなく、M3チップそのものがAIと機械学習(ML)を念頭に置いて設計されています。

Appleシリコンチップ全体がUMA(Unified Memory Architecture)というアーキテクチャで設計されていることは、実はあまり知られていないかもしれません。

ユニファイドメモリにアクセスすることでCPU・GPU間でメモリ割り当てを柔軟に行い、AI処理の負荷を分散させることができるのです。

GPU、CPU、Neural Engineそれぞれがメモリプール全体にアクセスし、必要に応じて動的に処理を割り当てます。M3 Max搭載のMacBook Proでは最大128GB、M2 Ultra搭載のMac StudioとMac Proでは最大192GBのユニファイドメモリを使えることになります。

同程度の負荷を想定した場合、他機種で処理を行うには複数台のGPU接続もしくはプロユースのハイスペックGPUが必要となり、ハードウェアの組み立て設置から必要なソフトウェアの準備まで、手間とコストがかかります。

Macでは単体で見たGPU性能や拡張性こそ劣る面もありますが、はるかに手軽で低コストに学習を回すことができます。

また、AppleシリコンのCPUは、AIの演算処理を高速実行するMLアクセラレータを搭載しています。

GPUは負荷の高いAIやMLのタスクに対応するパワフルさを持ち、また前述のように稼働メモリの大半をGPUメモリに充てることができるため、特に最新の大規模言語モデル(LLM)やプロ向けアプリのAI機能の実行に非常に向いているのです。

ローカルで実験を行う際は電力効率も気になる部分ですが、Appleシリコンではワット当たりのパフォーマンスが最適化されているのもポイントです。

エネルギー使用量やバッテリーを保ちつつ、効率的にAIやMLのワークフローを実行できます。

MacとAI機能開発

2017年から、MacではCore MLという機械学習のための開発フレームワークが提供されています。

Core MLCore MLにはVision(画像認識)、Speech(音声テキスト変換)、Natural Language(テキスト解析)、Sound Analysis(音の分類と解析)といった機械学習APIが初めから組み込まれており、無償の開発ツールであるXCodeからすぐに利用できます。複雑な環境構築は必要ありません。

オープンソースのため、TensorFlowやPyTorch、ほかのプラットフォームで作られたモデルをAppleシリコンで最適に動作するよう変換も可能です。

また、これもあまり知られていないのですが、Microsoft Copilot及びCopilot Pro、Copilot for Microsoft 365もMac上でスムーズに動作します。

Adobe・Zoom・Slackといったデベロッパーは既にAppleの開発フレームワークを存分に活用しており、音声テキスト化や生成AIによる編集の提案など、Macアプリは機械学習の力でよりパワフルに進化を続けています。

もちろんmacOS Sonomaも、Core MLを活かして機械学習の知力をOS全体に行き渡らせています。

周囲の雑音から声を分離したり、言語の翻訳やテキスト予測をしたり、画像から被写体を切り離したり……と、生産性を向上させる機能が日々追加されていることは実感があるかもしれません。

終わりに

これまで「AI・ML分野では、何台もGPUを繋いだ超ハイスペックPCが必須」と言うイメージを持たれていた方も多いのではないでしょうか。

もちろん最先端の開発ではグラフィックボードの増設は必須であったり、NVIDIAのGPUを使いたい場面も多々あるかもしれません。

しかし、Appleシリコンの設計思想・ローカルLLMの進化・ハードウェアスペックの向上といった現状を踏まえて考えると、Macはコスト面と簡便さで圧倒的に優れた選択肢と言えます。

そして、Apple製品の性能は今後ますます機械学習を前提に発展していきます。

2023年には、Appleが開発した大規模言語モデル「Ferret」や、Appleシリコン専用のオープンソースの機械学習フレームワーク「MLX」の公開など、既に同分野の技術開発も相次いでいます。

AI/ML分野で利用するMacが気になった方は、機種、容量、カスタマイズ、購入方法など、幅広く相談を承りますのでお気軽にお問合せください!

Macは、米国およびその他の国で登録されたApple Inc.の商標です。

Macは、Apple Inc.の商標です。

記事は2024年5月 8日現在の内容です。

この記事に付けられたタグ

おすすめ記事を見る