7月14日(木)に配信された「世界トレンド1位2位独占!キズナアイxRライブの作り手が語るメタバースの現実」より、セッション3「熱狂を生むメタバースエンタテインメント開発制作のリアルPart2」のウェビナーの内容をご紹介します。

- 主催 :株式会社Too

- 協力 :Activ8株式会社

- 協賛 :オートデスク株式会社

- 講師 :Activ8株式会社 テクニカルディレクター 肥田野 暢也 氏

1000人同時出演への取り組み

私からは、テクニカルディレクターの視点で、主にシステム関連の説明をしてきます。キズナアイのラストライブであるhello, world2022には「歴史に残る伝説のライブにしたい」、「新しい時代を駆け抜けた多くの仲間たちと同じステージに立ち、感謝を伝えたい」という2つの願いがコンセプトとして込められていました。

このコンセプトを実現するために、「1000人の仲間と同じ舞台に立とう」という前代未聞のミッションが掲げられました。

こちらはライブ冒頭部分の画像ですが、キズナアイの後ろに数多くのアバターがいることが確認できます。見ての通り、アバターはそれぞれ1人1人違うモデルになっています。ゲームのモブキャラとは違ってそれぞれのこだわりとアイデンティティをもとに1つ1つのアバターがある本件においては、既存のゲームでよく使われる一般的な群衆シミュレーションの手法は効果が発揮できないと考えました。

そのため、今回のライブ用に表現の仕様の策定から設計、検証、運用までを一貫して自社で行いました。最終的に13万人が見守る中でライブを成功させたその手法について、画像と一緒に紹介していきます。

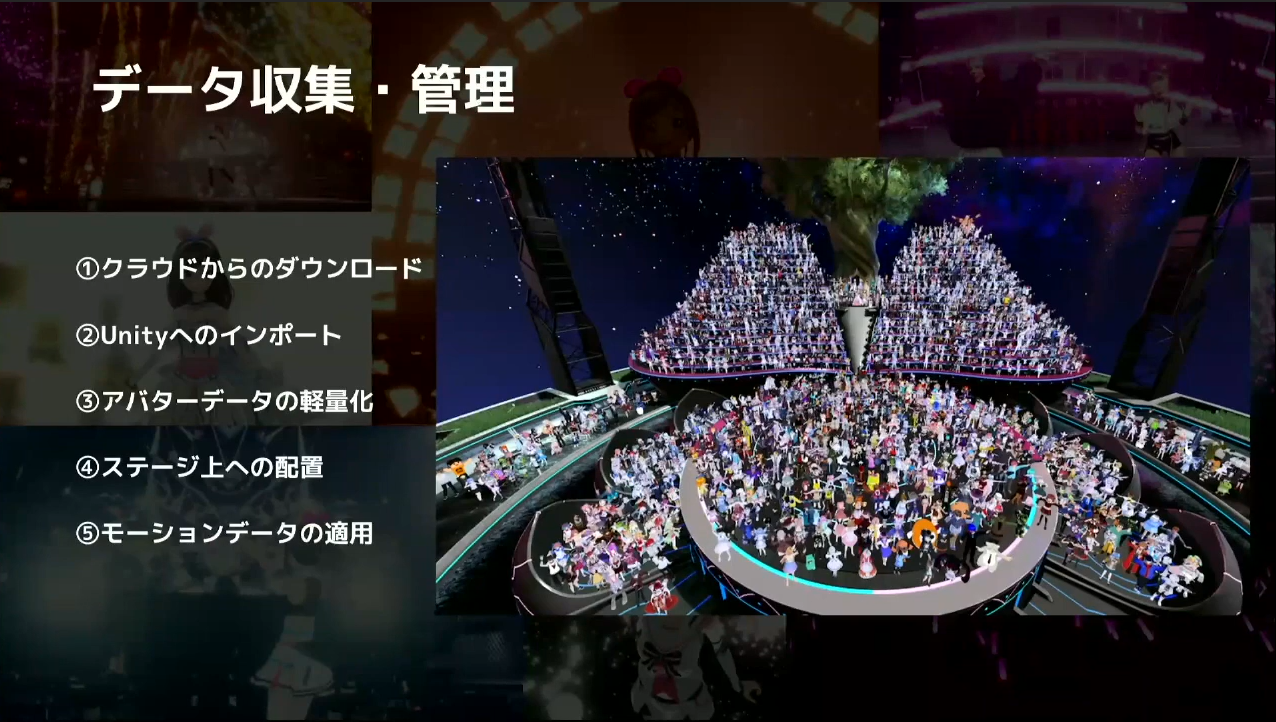

今回は大量のデータ処理のために共通の規格が必要だったため、アバターの共通フォーマットとして広く使われているVRMを使いました。一般公募のVRM形式のアバターデータに対し、

- クラウドからのダウンロード

- Unityへインポート

- アバターデータの軽量化

- ステージ上への配置

- モーションデータの適用

などのすべてのフローを自動で処理するパイプラインを構築しました。

上の画像の右側は、ライブ後に参加者全員へ配られた集合写真です。写真に写っているのは総勢で約1,600人ほどです。この写真も本編とは別で制作することが決まったのですが、アバターの処理を自動化したことで比較的低コストで対応することができました。

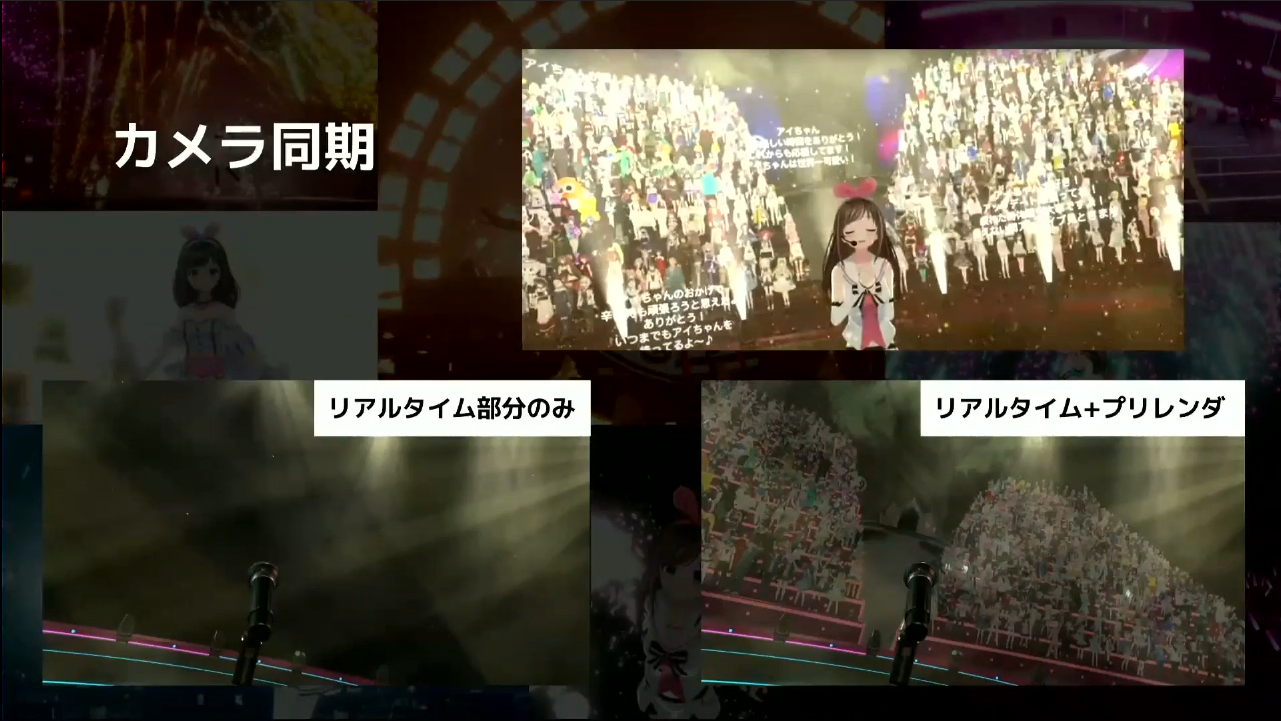

次に、「カメラ同期」についてです。hello, world2022は全編リアルタイムレンダリングなのですが、この数のモデルデータを同時にリアルタイムにレンダリングするのは技術的に不可能です。

そこで私たちが最初に考えたのは、事前に映像を書き出してから立て看板のようにステージ上に配置する「ビルボード」という手法でした。しかし、このやり方ではカメラの画角が大きく制限されてしまい、横から回り込んだときや上から見下ろしたときに映像がペラペラになってしまう不都合がありました。今回はCG空間でキズナアイと一緒に共演したいという願いがあったこともあり、一体感が損なわれてしまう手法は避けようということで、この手法は使わないことになりました。

最終的に、事前にカメラワークを作成し、その画角に合う映像をプリレンダする手法に決定しました。上の画像の下部左側が、リアルタイムにレンダリングしていたステージとマイク、キズナアイのみの画像です。そこに後ろのひな壇とアバターのデータをプリレンダして同じフレームで重ねることで、同じ空間にいるように見せることができました。

つまり同時に動画データを再生していることになるのですが、『Hap』というストリーミング再生に特化した動画規格を使ったおかげで、フルHDでも遅延なく再生することができました。

プロの技術を活用!バーチャルカメラで映像に革命を

次のトピックは、「プロの技術を活用!バーチャルカメラで映像に革命を」です。私たちは、前回のhello, world2020からバーチャルライブにおけるカメラワーク制作の強化に継続して取り組んでいます。カメラワークにおいてはhello, world2022で1つの到達点に辿りつけたと感じていて、ここではそのときのバーチャルカメラの極意を簡単に紹介していきます。

上の画像は、過去のライブのスクリーンショットを並べたものです。バーチャルライブの映像ではUnityの「Cinemachine(シネマシーン)」というカメラワークの機能が一般的で、キズナアイの初期のライブではよく使っていました。

しかし、画像左上のhello, world2020をきっかけに、人間のカメラマンによる生のカメラワークにこだわりたいという思いが芽生え始めました。左側の写真に載っているのは『RedSpy』という機材で、実際のカメラマンのカメラの動きをトラッキングしたりできます。

画像の真ん中にあるのは、Virtual US Tourおよびバーチャル花火ライブで使用した機材『VIVE Tracker』です。ローコストな上、工夫次第でハイクオリティなカメラワークが実現ができる機材です。画像右側のhello, world2022では、『VICON』のプロップを使うことでスタジオ内でカメラワークを作ったりと、様々な手法を試しながら検証をしていました。VICONを活用して直接手に持ってカメラを動かすとカメラの重さがモーションに伝わるため、人が撮っている感じを演出することができました。

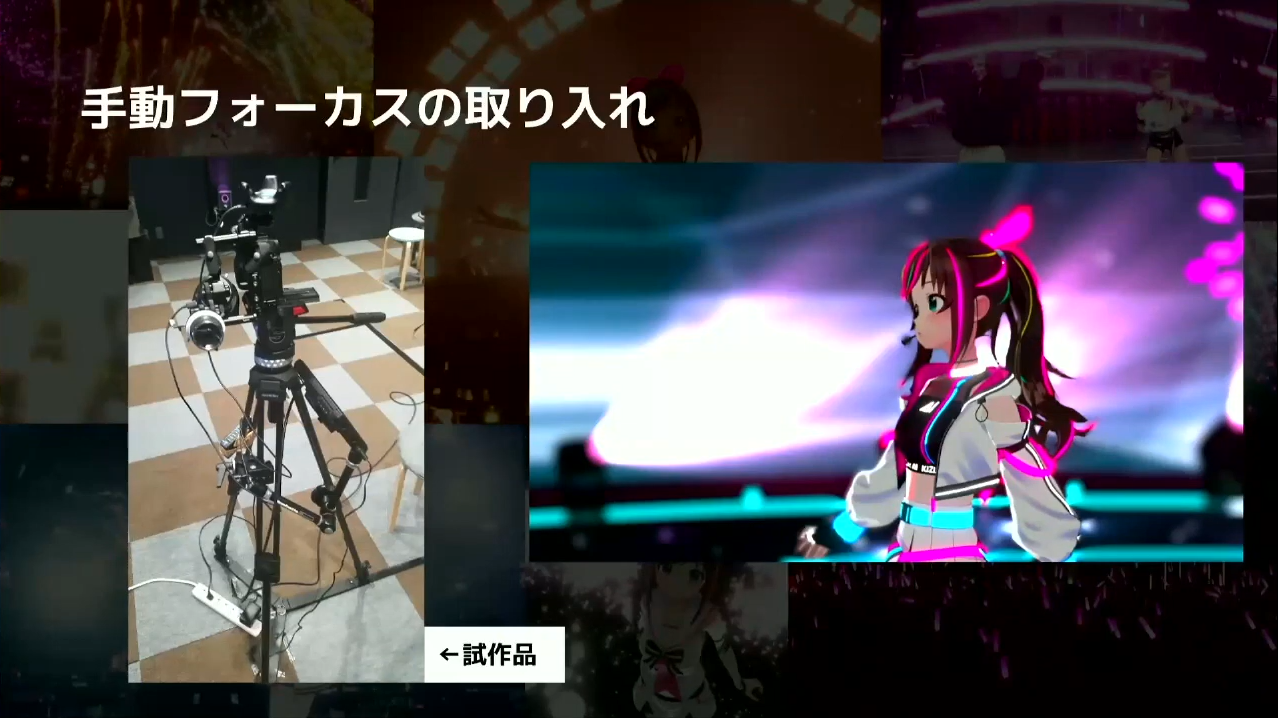

次に、「手動フォーカスの取り入れ」について説明します。hello, worldのライブには手動フォーカスを取り入れていて、被写界深度を活用することで右側の画像のように少しぼかした感じで発光部分を強調させることができます。また、ピントをキャラクターに合わせることで、より一層キャラクターの存在感を際立たせることもできます。

この手法自体は、ゲームエンジンの機能としては目新しくありません。しかし、ゲームエンジン内で設定せずに画像左側にある自作のデバイスを使って直接カメラマンの方に撮影してもらうという手法は、hello, world2022で初めて取り入れました。画像にあるのは試作品のため格好いいと言える見た目ではありませんが、その後もハードのブラッシュアップを続けていて、今も制作中のライブの案件で採用しています。

これらのデバイスによって深みのある映像表現が可能になり、本編中においても印象的なカットを数多く実現することができました。

V-Anim8orとは?

少し宣伝気味になってしまいますが、これまで紹介した技術の支えになっているツールについて軽く紹介していきます。

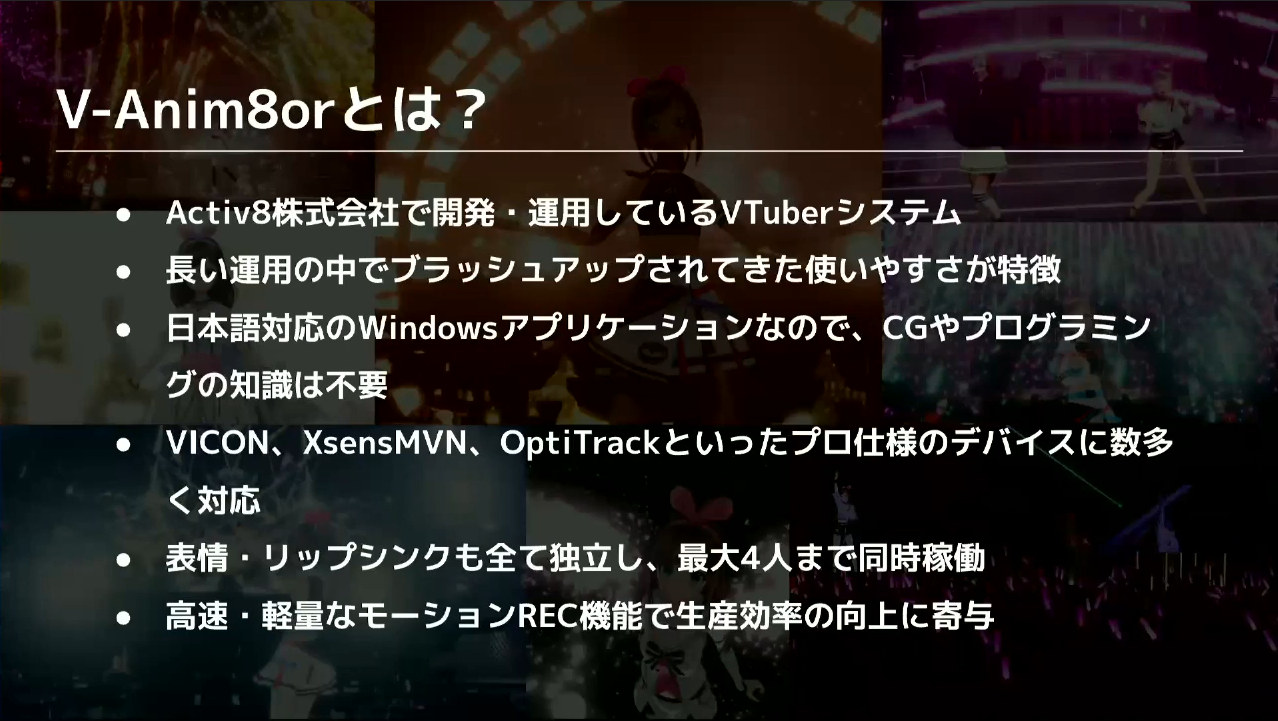

『V-Anim8or(ブイアニメーター)』とは、本ウェビナー主催の株式会社Too様と一緒に開発しているVTuberのためのシステムです。長い年月をかけて自社IPのために使ってきたノウハウを濃縮したようなシステムになっています。

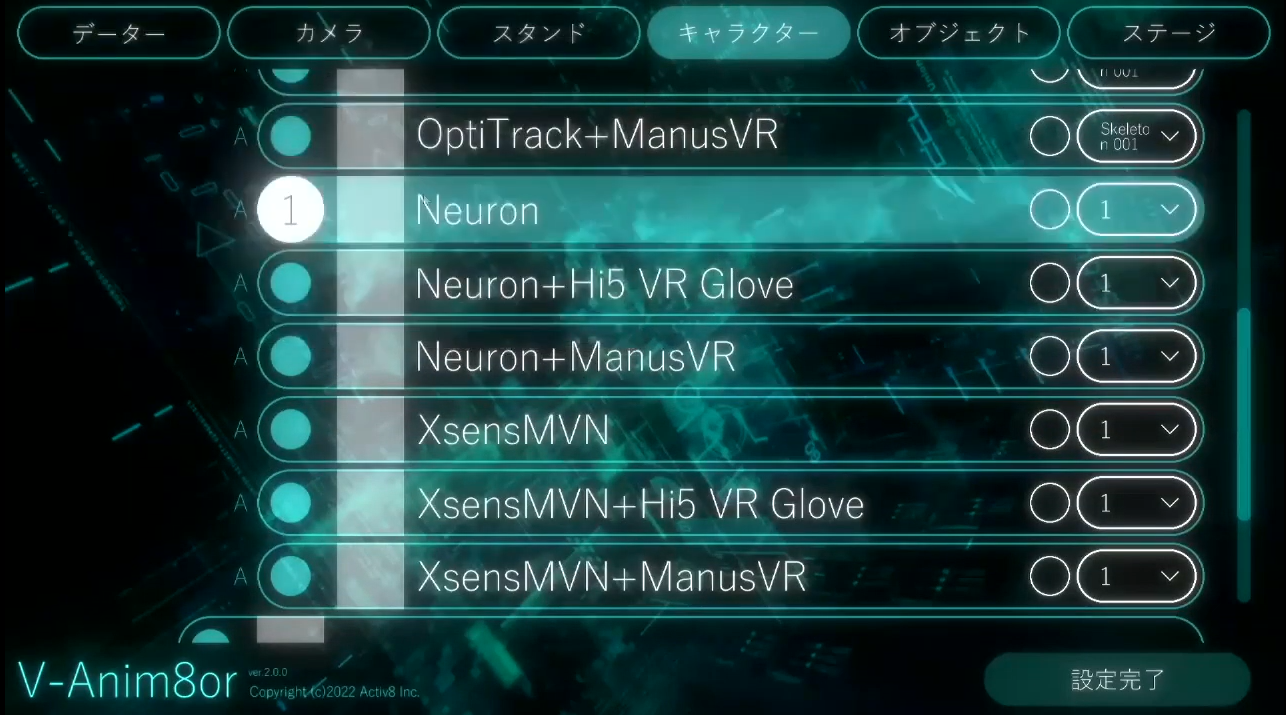

少し深掘りしてシステム的な魅力を紹介すると、上の画像3点目の「日本語対応のWindowsアプリケーション」が特徴的な点です。VTuberシステムをUnityデータから直接利用している方も多いと思うのですが、V-Anim8orはビルド済みのWindowsアプリケーションで日本語UIとなっているため、専門知識のない方でも気軽に利用できるものになっています。

そのうえでVICONやXsensMVN、OptiTrackなどのプロ仕様のモーションキャプチャデバイスにも対応していて、手軽にリッチなモーションを使ったコンテンツが作れるのも特徴の1つです。

また、隠れた魅力の1つに最大4人同時稼働が可能という点があり、表情やリップシンクも4人別々で同時稼働できます。モーションREC機能も独自で開発していて、高速かつ軽量で使い勝手のいいものになっています。

今回新しくリニューアルした2点について説明していきます。1点目が「VRMモデルのランタイムロードに対応」という点です。今までは、Vアニメーターを使って収録するときは事前にお客様からモデルデータを預かり、それをUnityで組み込んでビルドしてスタジオに持っていくというフローがありました。これからは、VRMモデルがあればそのまま直接読み込ませることで、エンジニアの手を介さずに動作させることが可能になりました。

2点目は、「CRI-LIPSYNCに対応」についてです。リップシンクには『CRI-LIPSYNC』を採用しています。CRI-LIPSYNCはディープラーニングを活用した高精度なリップシンクで日本語の母音とも相性がよく、音声調整せずとも流し込むだけで形通りに処理してくれる高品質なプラグインになっています。

Unityでマルチチャンネルの音声入力を使うのは難しいことなのですが、マルチチャンネルの入力もバッチリサポートされています。

ここからは、実際にV-Anim8orの使い方を見ていきます。WindowsアプリケーションのためEXEファイルを起動するだけであり、実行にUnityエディタなどは必要ありません。

「キャラクター」の部分から、VRMのランタイムロードを試していきます。今回は、VRoid様からフリーで配布されているモデルをサンプルとして使っています。

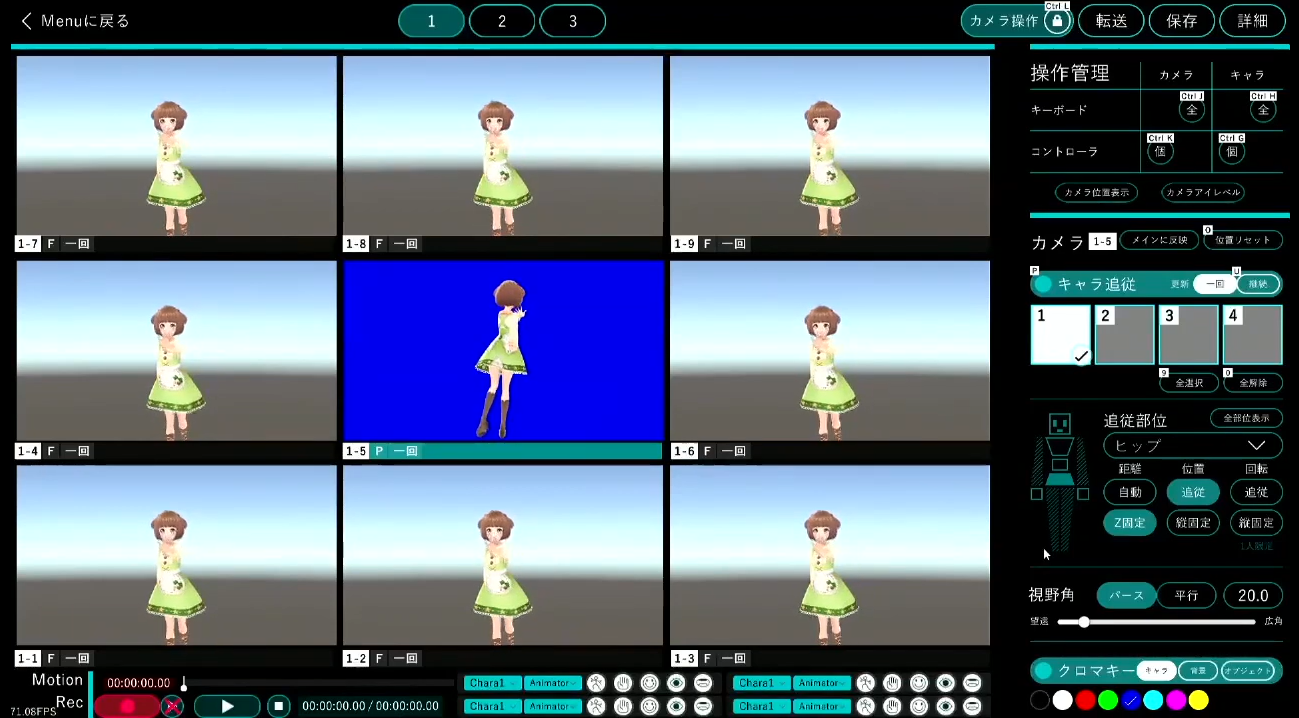

そのまま設定完了するだけで、モデルの組み込みをしなくてもVRMの表示ができました。ソフトの使い方として主に2つの画面があり、上の画像がメインの画面としてOBSなどでキャプチャするための画面です。

そして、上の画像が操作画面です。操作画面は9つのカメラで構成されていて、それぞれの画面でカメラ操作や動きに合わせたキャラクター追従、クロマキー設定などができます。また、VRMに標準で組み込まれている表情であれば読み取って使うことができます。特殊な表情も、ビルドファイルと一緒に付いてくるjsonファイルで設定できます。基本的な表情である4種類+目閉じには対応しているため、一般的な利用には十分だと思います。

モーションREC機能についても、画面左下にあるRECボタンを押すだけで簡単に撮ることができます。ライブ案件などで30分以上撮ったモーションデータでもモーションの書き出しで硬直する時間が1秒未満であったり、非常に軽量になっています。

ここでもう1つ、RECしたモーションに対して表情だけを上書きできる機能について説明します。この表情の上書き機能を使うと、モーションキャプチャの現場でありがちな「体の動きと表情の動きを一緒に撮るときに表情を間違えてしまったせいでもう1テイク」ということをする必要がなくなります。これによって、現場の負担は軽減されると考えています。

Activ8って今何をやっているの?

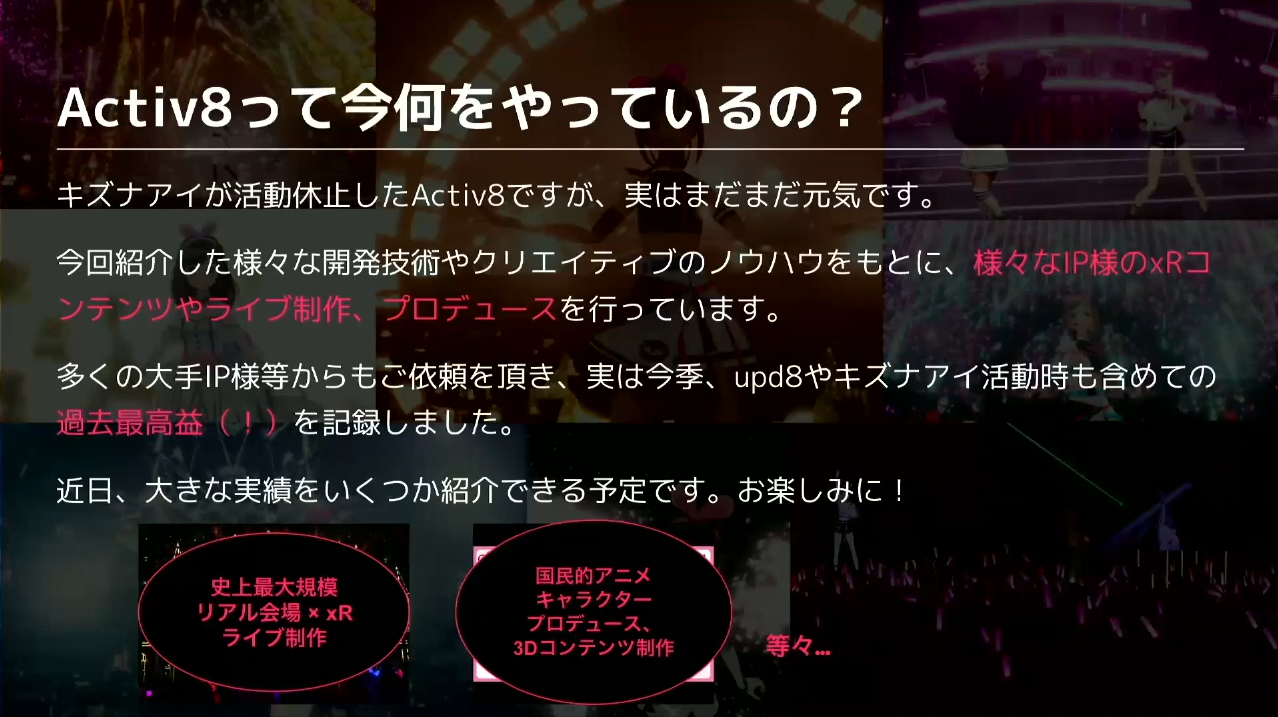

ここからは、「Activ8って今何をやっているの?」という話をしていきます。キズナアイが活動休止した現在のActiv8ですが、今回紹介した様々な開発技術やクリエイティブのノウハウをもとに、IP様のxRコンテンツやライブ制作、プロデュースを行っています。

画像の下にもある通り、「史上最大規模のリアル会場 × xRライブ制作」や、「国民的アニメキャラクタープロデュース、3Dコンテンツ制作」など、幅広く活動しています。

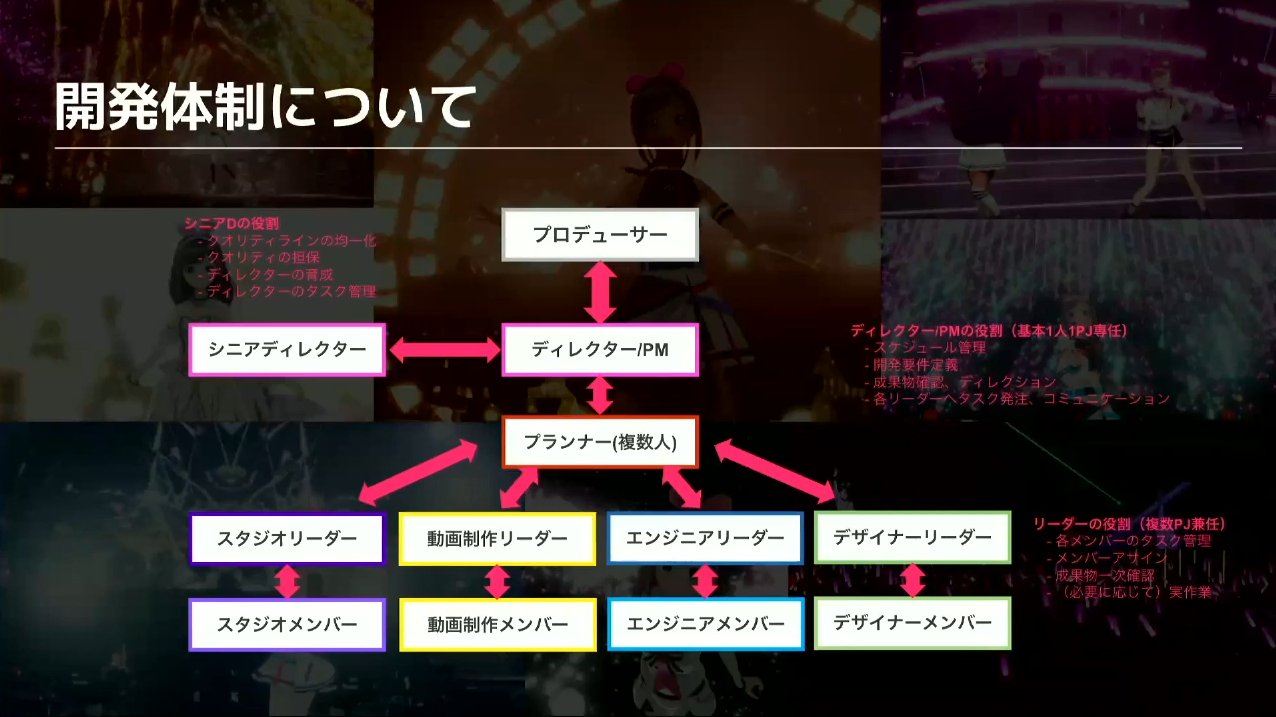

そういった大きな開発をする上での「開発体制について」ついて話をしていきます。画像のように、ゲーム業界のタイトル制作に近い体制になっています。一番上にいるプロデューサーの下のディレクターがPMも兼ねていて、ここに開発の情報が集積しています。プランナーや各セクションのリーダー、制作メンバーに情報を渡しつつ、制作されたものの実装確認などは逆の流れで行うという体制を敷いています。

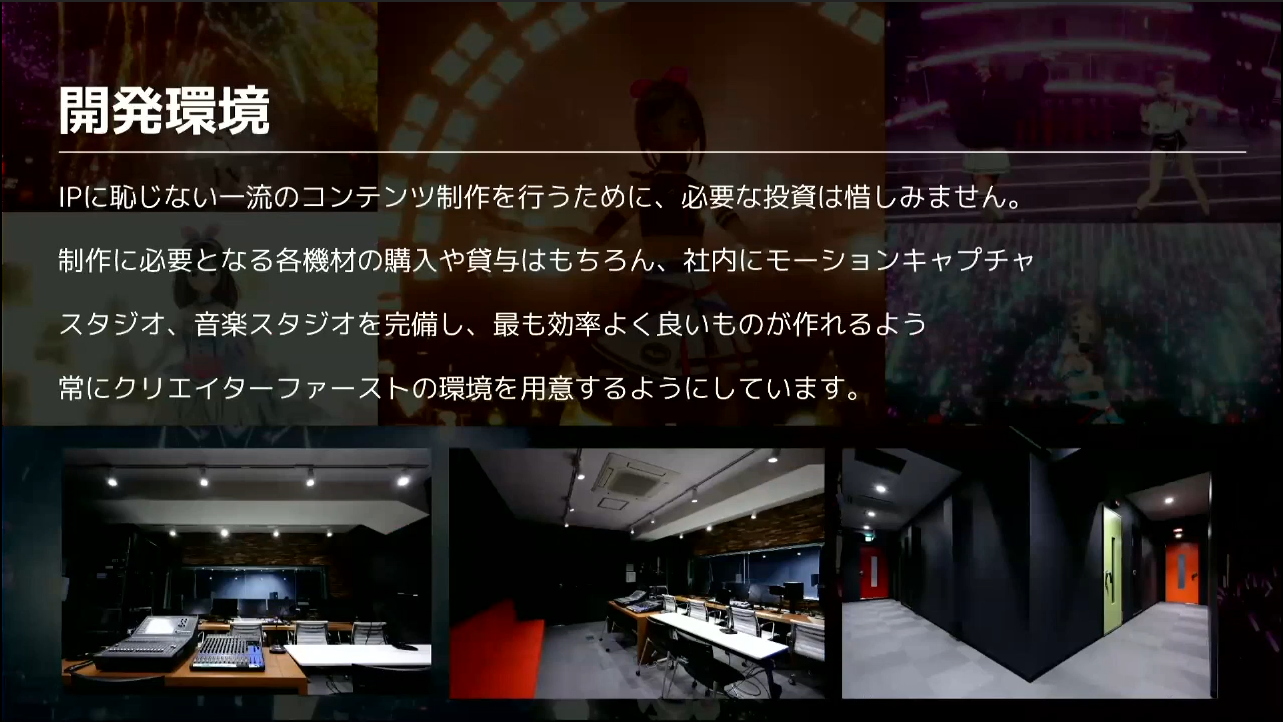

次に、「開発環境」の話をしていきます。IP様に恥じない一流のコンテンツ制作を行なうために、必要な投資は惜しまないようにしています。機材面も含め、社内にモーションキャプチャスタジオや音楽スタジオを設けるなど、最も効率よくいいものが作れるようにクリエイターファーストの環境を用意するようにしています。

質疑応答

Q1. バーチャルライブのオーディオまわりはどのような環境ですか?なんらかのミドルウェアを使ってUnity上にミキサーを構築していますか?外部で物理的な卓でミックスしていますか?

先に結論を言ってしまうと、外部で物理的な卓でミックスしています。Unityにも歌声や話し声を入れる必要があるため、物理卓から1本線を伸ばしてUnity上に上げています。ミドルウェアについては、さきほど紹介した株式会社CRI・ミドルウェア様のCRI-LIPSYNCを使っています。専門に作られたプラグインということもあって、非常に使い勝手がよく愛用しています。

Q2. バーチャルライブにおいて、バーチャルカメラと実写のカメラの使用台数の差はどれくらいありますか。

作り方によって変わりますが、バーチャルカメラは結構台数が増えがちです。Virtual US Tourやバーチャル花火ライブでは、合計で約50台ほどのバーチャルカメラを用意していました。一方で、hello, world2020の実写のカメラは2つか3つだけで、それらをうまく使い回しながら撮影していました。どうしても実写のカメラはコストがかかる部分のため、バーチャルカメラで補ったりという工夫が必要です。

また、バーチャルカメラの仕様上、曲を何度も再生して1人のカメラマンの方に何台分も撮ってもらうことが可能です。そのため何台ものカメラを用意する必要がなく、機材のコストを抑えられるという特性もあります。

Q3. VRMで1600人の大量のアバターデータを集めて処理をした際に、VRMのファイルや仕様で困ったことはありましたか?

当時は募集要項でUnityのバージョン0.60付近と指定をしたのですが、実際に集まったデータを見ると全部バラバラで、どちらかと言えば新しいバージョンのファイルが多いという状況でした。これに関しては、私たちが用意していたシステムを最新版に更新することで解決しました。

中にはそれでも通過しなかったモデルが5つほどあったため、手作業で直してVRMへエクスポートし直すことで対応することができました。柔軟なシステムで助かったと思ったことを覚えています。

Q4. 手動のフォーカスのシステムでは、カメラからの距離にフォーカスを当てるのか、それとも被写体にフォーカスが当たって、その被写体からのズレを操作するのか、どちらなのでしょうか?

前者のイメージです。被写界深度は固定値で、レンズからの距離だけをダイヤルで調整していました。カメラ自体は動き回らずに1ヶ所に固定して三脚で追いながらの撮影だったため、カメラマンの方に慣れてもらうのに多少のトレーニングも必要でした。

Q5. VTuber事業の企業に技術職での就職を希望する場合、学生のうちに身につけておくべき技術・スキルはありますか?UnityやMaya、Blenderなどの開発ソフトの経験や、TOEICやTOEFLなどの英語能力は必要でしょうか?

技術・スキル面に関しては、VR関連は基本的にUnityで作られていることが多いため、Unityは触っておくべきだと思います。Unityのコードが組めない場合でも、タイムラインのスクリプティングができるなどの技術は非常に役に立つと思います。

エンジニアの方であれば、「C#」などが扱えると非常に有利です。あとはトレンドを押さえておく事も重要で、例えばVRチャットについて知っていて、VRチャットがどのように作動しているのかを理解していれば強みになるのは間違いありません。

しかし、個人的にそれら以上に重要だと思っているのが、就職したいVR関連業界の様々なサービスの研究です。ユーザー感覚であろうと、それぞれのサービスの特性やユーザー層を研究しているだけでも武器になると思います。

また、学生の方の場合は、今高いスキルを持っていることよりも入社後の学習意欲と伸びしろの方が大事だと思っています。そこで質問にあったTOEICやTOEFLなどの英語の話につながるのですが、英語に関しては拒絶してしまうレベルでなければ仕事はできると思います。Unityのシステム周りの課題は日本語ページに解決方法が載っていないことも多いため、その場合に英語の掲示板やリファレンスページなどをチェックすることが多いです。そのため、英文を見た時に「とりあえず読んでみよう」と思える意欲さえあれば十分に仕事はできると思っています。

あと、学生の方はAUTODESKの製品が無料で使えるということを知ってほしいです。MayaやMotionBuilderなどを無料で習得できる絶好の機会のため、興味ある方はぜひ試してみてください。特に、バーチャルYouTuber・バーチャルライブ事業において、MotionBuilderは需要に対して扱える人が少ないという現状があります。そういった需要と供給の観点から見ても、個人的にオススメの学習領域だと思います。